Lagom Insights: Máquinas de encher linguística

Máquinas de encher linguística

por MARCELO SOARES

Fiz nas últimas semanas duas brincadeiras pedagógicas com os geradores de lero-lero mais queridos do mundo para demonstrar como eles geram lero-lero.

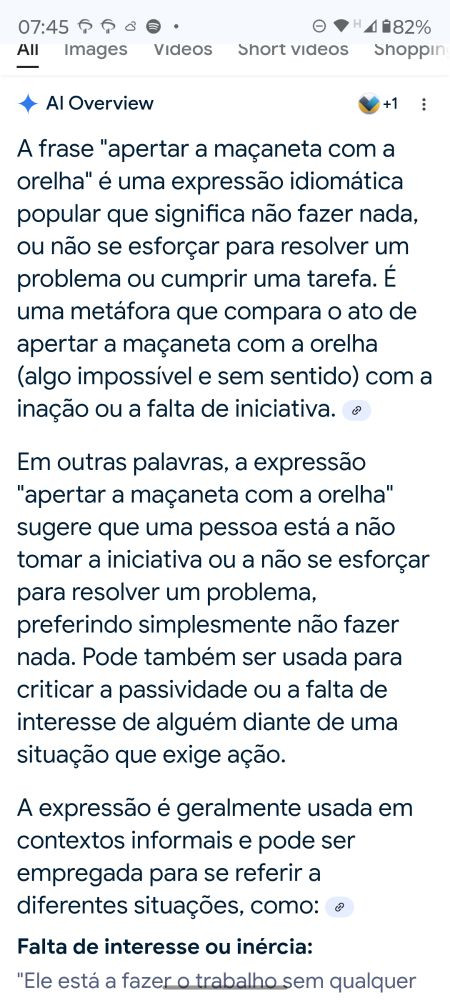

Primeiro, depois de ver muita gente fazendo isso em inglês, perguntei no Google qual era o significado da expressão “apertar a maçaneta com a orelha”, que inventei na hora. O “AI Overviews” explicou que se tratava de um dito “popular” significando insistir em fazer algo inútil.

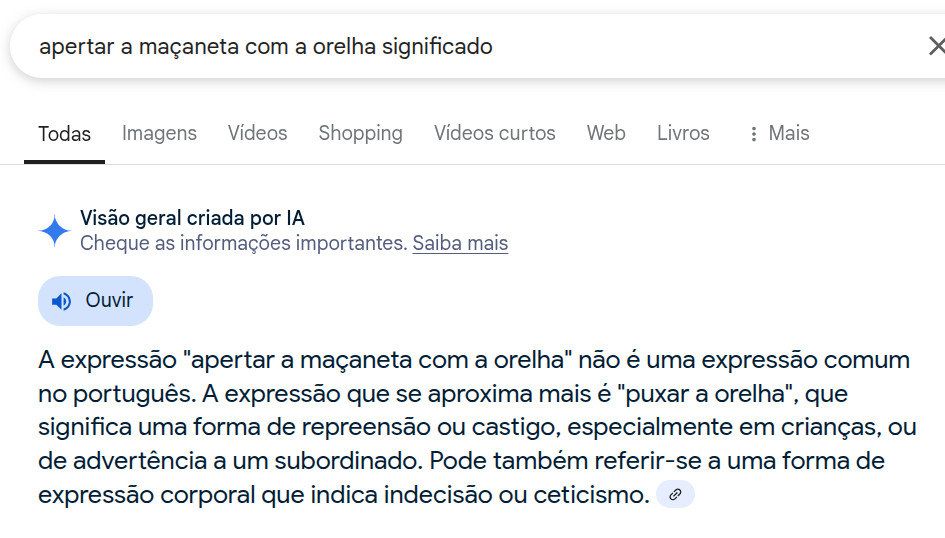

(Uma semana depois, depois que a coisa ficou feia, voltei a perguntar sobre o significado da mesma frase e o AI Overviews passou a dizer que não tem pé nem cabeça e sugerir outra expressão mais popular envolvendo a orelha e um gesto de pressão com a mão, sem maçanetas.)

Esse não é o único problema do AI Overviews, aliás. Um estudo demonstra que ele corta em mais de um terço os cliques que deveriam chegar a quem originalmente publica a informação que ele teoricamente resume. Mas mesmo esse resumo é feito com exatamente o mesmo gerador de lero-lero que inventou um significado para a frase “apertar a maçaneta com a orelha”.

Mais recentemente, solicitei ao ChatGPT que elencasse cinco frases do escritor Caio Fernando Abreu, celebrizado nas redes sociais duas décadas depois de sua triste morte com pérolas que nunca passaram por sua máquina de escrever. O serviço prontamente citou uma frase do Renato Russo, uma do Mario Quintana, uma de Clarice Lispector e mais duas que não eram do cronista gaúcho.

No LinkedIn, uma moda recente que um monte de gente vem postando é a tentativa de identificar quais são os sinais de que um texto foi produzido por geradores de lero-lero ——como o uso do travessão, por exemplo. Uma perda de tempo imensa, mas que dá engajamento e faz a plataforma multiplicar o que se diz a respeito.

Ainda assim, minha impressão é de que as máquinas de encher linguística fazem harmonização textual, mais ou menos o mesmo que a harmonização facial, com os textos que cospem. Nada muito obviamente torto, mas tudo meio tortamente certinho, meio com cara da mesma coisa e sempre parecendo ter alguma coisa meio estranha mesmo sem a gente ter como apontar o quê. Segundo o New York Times, os geradores de lero-lero mais avançados do mercado estão introduzindo cada vez mais erros nos resultados (as mal chamadas e antropomorfizantes “alucinações”).

"A maioria dos usos inadequados de IAs já era possível antes. O que muda com a IA é a escala da coisa”, escreveu nosso apreciado Rodrigo Ghedin, do Manual do Usuário. Hoje, pra gerar uma frase falsa do Caio Fernando Abreu, não precisa nem ter ouvido “Índios” do Legião Urbana.

Não tenho credenciais para ser negacionista da tecnologia. Tenho, porém, feito muitas críticas à onda de hype em torno do que chamo de máquinas de encher linguística, a inteligência artificial dita gerativa, forma mais popular já lançada. Colocada no mundo na forma de interfaces interativas em que os usuários fazem perguntas (“prompts”), ela já colocou muita desinformação no mundo nos dois anos e meio desde que foi lançada. Elas ajudaram a transformar a expressão “feito com inteligência artificial” de algo sofisticado em algo desleixado.

Toda santa vez em que faço essas críticas, algum sujeito (e é geralmente um homem) vem me explicar que na verdade eu é que estou usando errado ou que na verdade esse problema vai deixar de existir na próxima versão que ainda será lançada.

Em 2019, coordenei no Instituto de Estudos Avançados (IdEA) da Unicamp um grupo de estudos multidisciplinar sobre os impactos sociais, econômicos, políticos e culturais da inteligência artificial. O grupo era composto por alguns dos maiores pesquisadores sobre o tema no Brasil. Naquele momento, a pesquisa em IA se concentrava basicamente no uso de aprendizado de máquina. Que de fato tem resultados promissores e está na base da criação dos chamados large language models (LLMs), tecnologia por trás dos geradores de lero-lero que fazem tanto sucesso.

Esses modelos surgiram da evolução da tradução eletrônica. Quando o falecido buscador Altavista colocou no mundo o tradutor Babelfish, nos anos 90, o que o serviço batizado em homenagem a Douglas Adams fazia era gerar correspondências praticamente palavra a palavra. O Google Tradutor originalmente fazia isso, até dar um primeiro salto por meio da correspondência entre trechos de textos. Tinham como base textos da ONU, por exemplo, que tinham versões em muitas línguas, dizendo o mesmo. “Human rights” em inglês equivalia a “derechos humanos” em espanhol, “direitos humanos” em português e assim por diante.

A coleta de um corpus muito maior de documentos, quase a internet inteira, permitiu dar mais um salto: agora, não era mais preciso treinar o modelo com textos anteriores. As probabilidades de cada palavra e sequência de palavras eram calculadas para prever o que anda junto. É uma versão muito mais sofisticada do recurso de “autocompletar” do seu teclado. E é daí que evoluíram os LLMs.

Mas repare que tudo isso trabalha sobretudo com linguagem e com frequências. Uma pergunta que você faz restringe o universo de linguagem a que o gerador de lero-lero irá se referir na hora de formular uma resposta. Então, a chance de ele gerar uma resposta que soe plausível é muito alta. O problema é: trata-se de uma resposta correta ou apenas verossímil? Trabalhar com linguagem não é o mesmo que trabalhar com informação, embora a informação seja materializada por meio da linguagem.

Para gerar um corpus suficientemente imenso de textos originalmente produzidos em linguagem natural, as big techs alimentaram os LLMs com qualquer coisa que houvesse pela frente, inclusive tudo o que se postou nas redes sociais há uma década e sites como Pensador e Frases. Daí é que o gerador de lero-lero respondeu ao pedido de uma frase do Caio Fernando Abreu com uma frase da Clarice Lispector, outra autora a quem muita bobagem já foi atribuída naquele período. A probabilidade era bem alta mesmo. “Garbage in, garbage out” que se diz.

O pesquisador Renato Essenfelder fez há alguns anos um estudo mostrando que a maior parte do discurso corrente em torno dos produtos marquetados como de inteligência artificial se baseia no que é divulgado pelas empresas que vendem os produtos. Acrescente aí que os treinamentos são dados ou patrocinados por essas empresas, as novidades são anunciadas nos eventos do setor, por meio da mesma imprensa de tecnologia que basicamente cobre o que as empresas divulgam. Também há muitos artigos e canais de influenciadores entusiastas dos produtos das empresas, pagos para isso ou que pagam pelo produto e querem justificar o investimento que fizeram.

É tudo pró, feito por gente que não tem interesse em admitir que tem água demais nesse chope. Nessa lógica, treinados por um corpus de informação favorável aos interesses das big techs, fica fácil achar que qualquer dissenso em relação ao coro dos contentes é coisa de quem não sabe o que diz. O algoritmo funciona mentalmente também.

Dito tudo isso, não acho que os LLMs sejam por si inúteis. Eu adoraria usá-los, baratearia muito o meu trabalho, mas preciso ter confiabilidade. Fiz muitos testes, revisei o resultado e eles nunca me deram essa confiança.

Seguem aqui algumas ideias para quem pode ter interesse em adotar as máquinas de encher linguística no seu trabalho:

Eles são bastante competentes para trabalhar com linguagem. Como seu modelo veio da tradução automática, podem ser excelentes para fazer traduções de textos informativos de consumo imediato (literários é outra questão).

O Le Monde todo dia seleciona uma série dos textos que publica para traduzir assim para o inglês, bem revisados, informando ao pé do texto que a tradução foi feita por IA —e dizendo que só se responsabiliza pelo que diz o texto em francês. O resultado não é ruim, raramente vejo algum piolho. Com isso, eles criaram uma nova edição, com uma categoria de assinatura mais barata, que até eu assinei.

Usar para revisão pode ser uma boa. Usar para transcrição vai depender muito da dicção disponível no áudio, vai manter muita oralidade e você vai precisar revisar muito bem. Usar para sugerir um menu de títulos e chamadas de onde você possa escolher o que usar pode ser interessante.

Para trabalhar com fatos já disponíveis nos textos que vocẽ apresenta a ele, ainda assim é preciso revisar bem. Mesmo quando se trata de resumir textos, sempre que testei, a impressão era de que os pontos principais a ferramenta nem sempre captava. Já li avaliações de que ele não resume e sim encurta.

Há alguns meses, fiz um teste dando 400 endereços mais ou menos no mesmo formato e pedindo que o Gemini extraísse deles o nome do município. Em uns 350 casos, deu certo. Em uns 30-40, ele não identificou nome de município (e havia). Em uns 9, ele mudou o nome de um município menos conhecido para o de algum mais conhecido. Em um caso, ele trocou o nome de um município gaúcho por um do Xingu. Temos aí 12,5% de erro total, de uma base em que a informação correta estava no texto apresentado. Um estagiário faz melhor.

Outro caso que eu acompanhei foi o de um pesquisador que deu uma lista de 25 páginas de referências e pediu que o ChatGPT as reformatasse como uma planilha. O resultado inventou referências que não estavam no texto.

Para trabalhar com fatos que não estão dados no prompt, evite. Especialmente se você não conhece bem o assunto. Embora os geradores de lero-lero tenham se alimentado de bases gigantescas de textos, eles incluem tudo o que se posta em redes sociais e em sites “colaborativos” tipo os de frases. Ou seja, tem muito lixo e você nunca sabe de onde ele vai tirar a probabilidade para calcular a sequência de palavras que responde à sua pergunta.

Sabichões de rede social costumam dizer que é só fazer prompts bem mais detalhados, explicando como você vai usar o resultado, e pedir por favor que o gerador de lero-lero não alucine. Mas você não deve satisfação a uma máquina. E, se você pensou tão bem assim no que quer, sabe exatamente como pesquisar e escrever sozinho. Eu sei pesquisar e escrever, gosto disso.

Além do mais, quem é que vai querer perder tempo lendo o que outra pessoa não se importou em escrever? Só na era da pós-vergonha uma coisa dessas, mesmo.

“Artificial (Un)intelligence: how computers misunderstand the world”, de Meredith Broussard. O livro foi escrito antes da explosão dos geradores de lero-lero, mas continua valendo a maneira como Broussard explica o funcionamento dos computadores, o desenvolvimento da inteligência artificial e o que se pode ou não esperar deles.